Nvidia domina en la mano. Y el problema de AMD es que lo es, pero en este momento no parece – Desde dentro

El problema de la AMD no es que no sea buenas GPU para IA. El problema es que incluso

El problema de la AMD no es que no sea buenas GPU para IA. El problema es que incluso el desarrollo aún no puede competir con Nvidia. La compañía acaba de elevar su nueva hoja de ruta con modelos prometedores, pero esto no es una garantía de un Nvidia que no permite que su posición de liderazgo absoluta escape.

El problema para AMD no es ser, sino ser consciente de los demás. Datos de asesoramiento de IDC indicar Este NVIDIA domina el mercado de chips KI con 85.2% de cola del mercado por 14.3% AMD. Otros analistas como Jon Pedie Research también van y Según sus datos La cuota NVIDIA en este segmento es del 92%.

AMD Instinct MI350 son solo el comienzo. Las GPU para IA, que AMD llama «acelerador», sigue su desarrollo. Durante el evento, presentaron su serie Family o Instinct -Mi350 con dos variantes, MI350X y MI355X. Según el fabricante, estos chips en el rendimiento general en relación con la generación anterior son cuatro veces más altas, pero están hasta 35 veces más en el campo de la inferencia -ai (es decir, en el uso práctico de modelos como Chatgt que tienen sus reacciones de nuestras entradas «infiere» sus reacciones de nuestras solicitudes de entrada. Pflops en precisión FP8.

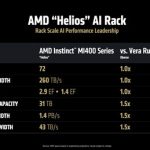

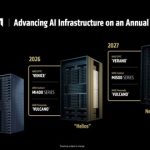

Instinct MI400 en 2026. La nueva familia de los aceleradores de AMD llegará el próximo año. Se trata Future MI400 Instinctque llegará con hasta 432 GB de almacenamiento HBM4, ancho de banda de 19.6 TB/s de esta memoria y una salida de 40 plantas en precisión FP4 y 20 PFLOP en precisión FP8. Estos monstruos se venderán en futuros estantes con infraestructura. «Helios«, El Puedes tener una casa Hasta 72 MI400 con un rango total de hasta 260 TB/s gracias a su tecnología de conexión, Ultra Acelerator Link.

Epyc Venecia. AMD no solo habló sobre GPU: también tiene sus futuros procesadores para servidores en centros de datos en pleno desarrollo. La Venecia EPYC llegará en 2026 y se basará en la arquitectura Zen 6. Entre las variantes hay un particularmente espectacular con 256 núcleos que ofrecen hasta un 70% más de potencia en comparación con la generación anterior. Estos procesadores se construirán con el futuro instinto Mi400. Se espera que TSMC los produzcan con el nodo N2P (2 -NM).

Helios contra Oberon. El rack helios mencionado anteriormente aún no competirá con el servidor NVIDIA AI actual que GB200 NVL72 Esto conecta 36 CPus Grace y 72 GPU Blackwell. Tiene la intención de competir con su sucesor que tiene el nombre en código de Oberon y usará las GPU IA B300 con la arquitectura de Vera Rubin. Las devoluciones y las ventajas de estos estantes futuros son absolutamente mareados y, por ejemplo, la potencia de precisión FP8 es 1.4 exafultos.

Lo mismo en algunas cosas, mejor en otras. AMD promete cumplir con Nvidia en varias secciones, pero también garantiza que sea notable (50% más) en la memoria y el ancho, lo cual es de crucial importancia para el entrenamiento y la inferencia. Tenga cuidado, porque al final de 2027, Nvidia prepara la arquitectura de Rubin -Ultra, que promete bastidores con hasta 5 exagulaciones en precisión FP8, tres veces más que Helios u Oberon.

En 2027 tendremos otro «verano». La hoja de ruta AMD continúa y ya ha preparado el desarrollo de su nueva generación de chips para los servidores EPYC de verano que reemplazarán la Venecia Epyc. Estas CPU se combinan con el futuro instinto de MI500X, y se espera que no sea cierto, que ambos tipos de uso de chips, el nudo ya anunciado A16 de TSMC (1.6 nm), que comienza a fines de 2026 que dependen de estos desarrollos.

Raza agitada. Todos estos anuncios muestran que AMD no quiere quedarse atrás en esta carrera para colocar sus soluciones en los centros de datos de todo el mundo. The Crusoe Company, que está dedicada a la construcción de grandes centros de cálculo de IA, Publicidad Hace unos días gasté $ 400 millones en Chips de AMD, e incluso Sam Altman, CEO de OpenAai, hizo una aparición sorprendente Durante la discusión inicial de Lisa Su, CEO del evento AMD. Altman dijo que también usará chips AMD en los centros de datos que use y enfatizado Que las nuevas GPU AMD IA «serán un poco asombrosas».

AMD sospecha que es más eficiente (y barato). El mensaje de la AMD fue claro durante el evento: su MI355 ofrece mucha más eficiencia y es más barato que NVIDIA B200 y GB200 con rendimientos comparables. No se conocen los precios de venta de esta GPU, pero sabemos que el MI300X de AMD a principios de 2024 Costan Un máximo de $ 15,000 para los más de 40,000 dólares estadounidenses que cuestan el NVIDIA H100.

El mayor desafío sigue siendo CUDA. Las ventajas de los chips AMD -ai no son el problema de esta empresa. Los estudios detallados mostraron hace meses que MI300X es claramente más alto que NVIDIA H100 y H200 en términos de rendimiento y rendimiento. Sin embargo, NVIDIA tiene un CUDA, el estándar de facto en la industria para servicios y aplicaciones de IA. El uso del software nativo de AMD es factible, sí, pero experiencia de software, Se aseguraron en semianálisis«El software está lleno de errores que has entrenado [modelos de IA] Es imposible con AMD. «

La esperanza de AMD es rocm. En este evento AMD, Rocm 7 también presentó el Última versión Desde su propia plataforma de programación de código abierto para sus GPU. En AMD declararon que esta versión es 3.5 veces más poderosa que ROCM 6, e incluso afirman que es un 30% más poderoso en el B200 que CUDA si sirve al modelo Deepseek R1. Sin embargo, indican En otro informe En algunas secciones todavía es más bajo. Si recibe este componente, los desarrolladores pueden cumplir con el potencial de los chips AMD suficientes para el futuro de estos esfuerzos. Incluso más que hardware, ahora AMD tiene que impresionar el software.

Imagen | Amd

En | El Director General de AMD tiene un propósito en China: romper el mercado de IA a NVIDIA